Wikipédia a longtemps incarné la porte d’entrée vers la connaissance libre, accessible à tous en quelques clics. Mais l’avènement des intelligences artificielles et la déferlante des nouveaux outils numériques modifient radicalement la donne. Moteurs de recherche boostés à l’IA, réponses instantanées, plateformes sociales ultra-visuelles : le géant de l’information fait aujourd’hui face à un véritable test de résistance. Comment cette encyclopédie collaborative réagit-elle face à la chute de sa fréquentation et à la transformation des usages ? Décryptage d’une mutation à la croisée de la technologie, de la culture et du modèle économique.

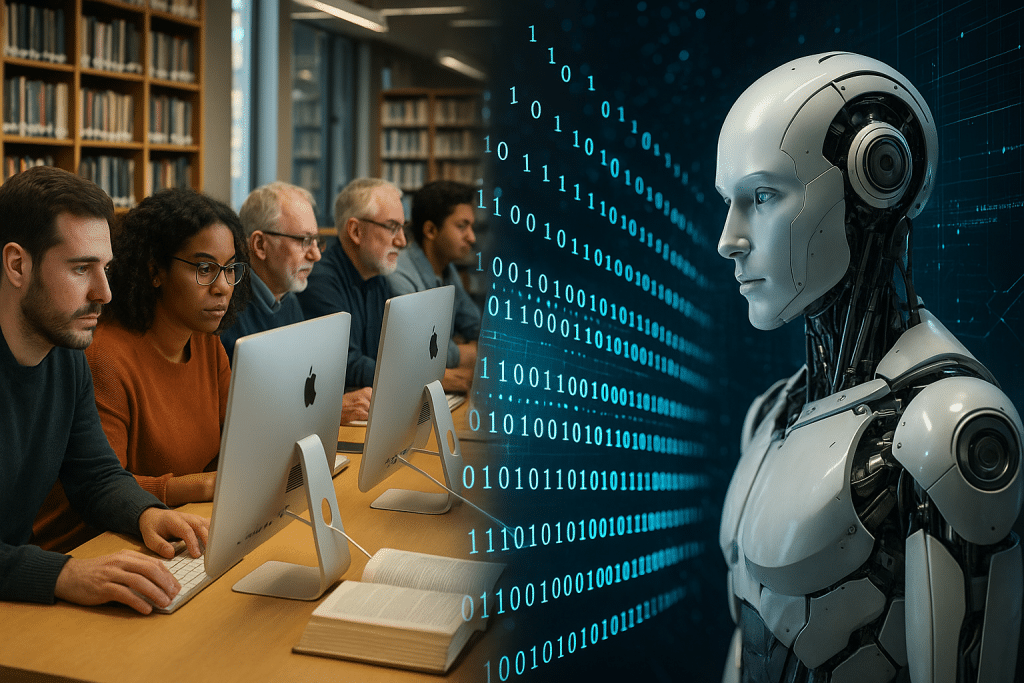

Wikipédia à l’épreuve de l’intégration massive de l’intelligence artificielle

La révolution de l’intelligence artificielle générative n’a pas seulement bouleversé la manière de chercher, consommer et vérifier l’information. Elle a commencé à saper les fondations des repères de confiance qui prévalaient jusque-là. Wikipédia, ce monument de la culture numérique, en fait l’expérience : la fréquentation du site a chuté de 8% en quelques mois, selon CNEWS, un recul inédit dans son histoire récente. Les internautes, de plus en plus nombreux, se rabattent désormais sur des assistants IA qui leur livrent des réponses toutes faites, en puisant souvent dans… Wikipédia elle-même.

La plupart des outils actuellement déployés par Google, OpenAI, Microsoft ou DeepMind, à l’image de ChatGPT ou Bing Copilot, exploitent direct ou indirectement Wikidata, Wikiquote ou WikiBooks pour alimenter leurs réponses automatiques. La simplicité d’une phrase synthétique ou d’un résumé sur smartphone séduit massivement. Si le réflexe de “googler” une information existait déjà, désormais, l’étape de visite du site Wikipédia passe à la trappe. Résultat : moins de clics, moins de visites, et une crise de visibilité qui inquiète la Wikimedia Foundation.

La contre-attaque des sites collaboratifs face à l’essor des IA génératives

Face à cette érosion de son audience, Wikipédia tente l’offensive sur plusieurs fronts. D’une part, la fondation mise sur des projets maison comme le Wikidata Embedding Project, cherchant à doter l’encyclopédie d’une couche d’intelligence artificielle maison, pour renforcer la fiabilité et l’accessibilité des données structurées. D’autre part, elle collabore avec des acteurs comme Euronews ou L’Avenir pour sensibiliser le public aux apports uniques du contenu collaboratif, vérifié et sourcé par des milliers de volontaires.

- Développement d’IA open source, pour rivaliser avec les géants privés.

- Partenariats avec des institutions éducatives et scientifiques pour renforcer la valeur perçue des données.

- Campagnes de sensibilisation à l’esprit critique, pointant les dangers des réponses générées systématiquement par l’IA.

- Mise à jour régulière des contenus via des chantiers communautaires mondiaux.

Dans ce contexte, l’enjeu n’est plus simplement la transmission du savoir, mais aussi la sauvegarde de la souveraineté et de la diversité des sources au sein de l’écosystème numérique. Car si Wikipédia perd trop de terrain, c’est le pluralisme même de la connaissance qui vacille. À l’heure où l’on s’informe de plus en plus à travers des IA et des réponses éclairs, l’indépendance éditoriale de l’encyclopédie devient cruciale pour maintenir la diversité intellectuelle.

Ce défi de visibilité n’est d’ailleurs pas isolé : beaucoup d’acteurs du web, y compris les médias traditionnels et les bases de données publiques, subissent le même phénomène. La question désormais est de savoir si la fameuse encyclopédie collaborative saura transformer cette crise en opportunité, ou si elle assistera impuissante à sa marginalisation sur la scène du savoir numérique. Passage obligé : repenser sa stratégie technologique mais aussi relationnelle, pour créer une nouvelle forme d’attractivité, à l’heure où tout s’accélère.

L’érosion de la fréquentation de Wikipédia, symptôme d’un basculement

Depuis plusieurs mois, les signaux d’alerte se sont multipliés pour la plateforme. En lien étroit avec la généralisation des interfaces IA, Wikipédia voit son trafic humain décliner, perdant du terrain face à de nouveaux canaux d’information ultra-rapides et personnalisés. Un article de Siècle Digital souligne l’effet domino des réponses générées en temps réel : les utilisateurs obtiennent ce qu’ils cherchent directement dans leur fenêtre de recherche, sans cliquer, sans générer de visites réelles sur le site d’origine.

Dans la pratique, cela se traduit par une série de comportements nouveaux :

- Recherche d’informations par interface vocale ou chat, sans lecture directe des articles complets.

- Consultation massive de vidéos, stories et posts courts, notamment sur TikTok ou Instagram, reléguant les textes longs à l’arrière-plan.

- Désintermédiation croissante : les plateformes sociales, Google, Bing et consorts injectent les infos Wikipedia dans leurs propres modules, sans passerelle vers le site original.

- Émergence de plateformes IA concurrentes – Grokopedia, Gemini Enterprise (détail ici), ou IA d’OpenAI et Microsoft – offrant des alternatives personnalisées et payantes.

Ce phénomène va au-delà d’un simple changement d’habitude de surf : il remet en cause l’économie de l’attention. La transformation touche le modèle participatif même de Wikipédia, qui repose sur l’engagement d’une communauté enthousiaste – mais de moins en moins exposée à la plateforme au fil du temps. L’effet boule de neige est difficile à enrayer, d’autant plus que l’IA elle-même s’appuie sur les contenus collaboratifs pour grandir. Ce paradoxe, ces outils puisant dans la ressource qu’ils affaiblissent, est au cœur de l’alerte soulevée dans Le Point.

Nouvelle concurrence et recyclage des savoirs : risque de cercle vicieux

Plus inquiétant encore, l’explosion des contenus générés automatiquement crée un terrain propice à ce que certains ont appelé “l’auto-démolition de la donnée” (détails ici). En recyclant, à l’infini, des extraits Wikipedia dans d’autres outils, le risque de dilution, d’appauvrissement, voire de perte de fiabilité, grandit chaque jour. La majorité des internautes ne s’en rendent pas compte, habitués à absorber des informations synthétiques, sans pister leur source réelle.

- Automatisation des réponses et réduction du temps passé à analyser les articles de fond.

- Recyclage d’erreurs potentielles à grande échelle.

- Baisse de l’implication des contributeurs bénévoles (découragement face à la perte d’audience ?).

- Difficulté à pérenniser le modèle économique basé sur les dons volontaires et la visibilité publique de la Fondation.

Ce glissement vers une consommation “prêt-à-penser” interroge donc toute la chaîne de la transmission du savoir et invite à s’intéresser aux défis pourront se poser dans la gestion de l’intégrité et de la qualité des contenus. Alors que la société numérique demande plus de fiabilité, plus de transparence, la solution ne se trouve pas dans la fuite en avant vers l’automatisation totale, mais dans l’invention de nouvelles synergies entre humains et IA.

Derrière cette crise de fréquentation, se cache finalement l’opportunité pour Wikipédia de repenser sa forme, ses outils, sa participation citoyenne. Les prochains développements s’annoncent passionnants, à mesure que l’encyclopédie doit séduire une nouvelle génération, friande de formats courts mais attachée à la fiabilité.

Prolifération des contenus IA : entre perte d’intégrité et enjeux éthiques

L’autre danger, pas seulement numérique, tient dans l’irruption massive d’articles générés par l’intelligence artificielle au sein même des pages de Wikipédia. Plusieurs études relayées par RTS et BFMTV mettent en avant l’inflation de contributions mal rédigées, mal sourcées, parfois manipulées ou déviantes. Sous couvert d’efficacité, des IA déposent des textes qui “semblent corrects”, mais altèrent la qualité encyclopédique, la neutralité ou l’exhaustivité des contenus.

Les modérateurs et volontaires sont alors confrontés à une charge de travail inédite :

- Dépistage des faux articles ou des contenus non attribués.

- Vérification des sources face à une cascade de textes semblant corrects mais non vérifiés.

- Débats autour de la validité et de l’objectivité des formations IA qui alimentent ces contenus.

- Perte de repères dans la structuration et la hiérarchisation des savoirs (= chaos potentiel pour les étudiants, chercheurs, enseignants).

C’est tout l’ADN de Wikipédia qui est pris à rebrousse-poil : la plateforme a bâti sa réputation sur le volontariat, la relecture humaine, la diversité éditoriale. Si tout se retrouve filtré par des algorithmes, le risque de voir s’installer un “monoculturel numerique” devient bien réel. Mais alors, comment sauvegarder la fiabilité dans ce déluge d’automatismes ?

Les communautés humaines, dernier rempart contre la déshumanisation des savoirs ?

Pour préserver son identité, Wikipédia encourage une mobilisation continue de ses communautés. Le bénévolat numérique et les chantiers collectifs ne faiblissent pas, comme en atteste le regain d’initiatives autour de WikiBooks, WikiCommons et Wikiquote. L’encyclopédie investit également dans la formation et l’accompagnement de nouveaux contributeurs pour développer leur esprit critique face aux suggestions automatiques des IA (source complémentaire).

- Création de guides d’identification des contenus IA destinés aux administrateurs et membres actifs.

- Organisation de webinaires sur les biais algorithmiques et la désinformation.

- Développement de modules de détection automatique de plagiats et de duplications IA.

- Valorisation des discussions et débats ouverts autour des choix éditoriaux (transparence sur les processus de modération).

Le retour à la vérification humaine, doublé d’une pédagogie active autour des usages de l’IA, apparaît donc comme la clé pour ne pas sombrer dans l’uniformisation. Si la communauté parvient à relever ce défi, Wikipédia pourrait bien s’imposer en rempart contre la dilution des savoirs, prouvant la pertinence du collectif face aux réflexes paresseux induits par la technologie dernière génération.

La bataille entre neutralité, diversité et automatisation, n’a jamais été aussi brûlante. Plus que jamais, futurs contributeurs et lecteurs sont au cœur de l’évolution de l’encyclopédie, artisans potentiels d’une renaissance face à la déferlante IA… ou témoins de son essoufflement.

Réseaux sociaux et vidéos courtes : nouvel eldorado de la transmission du savoir ?

Le coup de mou de Wikipédia ne s’explique pas uniquement par l’essor des IA génératives. Au même moment, l’explosion des formats courts sur les réseaux – TikTok, YouTube Shorts, Instagram Reels – attire des millions de jeunes, habitués à s’informer en quelques secondes, via des contenus ludiques très éloignés de la rigueur encyclopédique. Selon des analyses relayées par Frandroid, ces nouveaux médias jouent un rôle clé dans le basculement de l’attention en ligne, concurrençant la profondeur historique de Wikipédia.

TikTok et consorts n’hésitent d’ailleurs pas à intégrer des extraits de Wikipédia dans leurs vidéos, tout en détournant l’attention loin du site original. Ce cercle vicieux pose de vrais enjeux autour de la transmission :

- Circulation accélérée, voire superficielle, du “savoir encyclopédique”.

- Difficulté à garantir la fiabilité et la profondeur dans les formats très courts.

- Perte d’incitation au débat et à la contradiction publique.

- Absence de lien systématique vers l’article originel, fragilisant la démarche sourcée.

À la clé, une tension croissante : faut-il adapter Wikipédia aux usages sociaux (mèmes, infographies, mini-vidéos) ou, au contraire, préserver son ADN éditorial plus exigeant ? Certains chercheurs militent pour des ponts renforcés entre encyclopédie et réseaux sociaux, via des chatbots, des vidéos éducatives estampillées, ou même des relais officiels sur Instagram, TikTok ou YouTube.

Vers une “médiation du savoir” nouvelle génération

Certes, ces nouvelles pratiques n’enlèvent rien à la richesse des bases de données comme Wikidata (exploitée par les géants comme DeepMind). Mais la démocratisation des connaissances suppose de repenser aussi les modes de partage et d’interaction. Des expériences comme l’utilisation de l’IA sur YouTube pour estimer l’âge réel des utilisateurs (plus d’infos) témoignent de cette volonté d’affiner la diffusion à chaque public.

- Création de contenus originaux adaptés aux plateformes sociales.

- Inclusion de liens directs et visibles vers Wikipédia et ses projets dérivés.

- Organisation de live interactifs et sessions Q&A animées par des experts.

- Suivi de la performance par l’analyse des données et des retours utilisateurs.

Si le format vidéo ou la viralité du post ne remplacent pas la profondeur encyclopédique, ils peuvent, bien orchestrés, devenir un tremplin pour réamorcer la curiosité, provoquer le déclic d’une lecture complète. Wikipédia, bastion du savoir écrit, peut ainsi s’ouvrir – intelligemment – à la médiation nouvelle génération, sans renier ses racines.

La clé reste l’alliance entre technicité, créativité et pédagogie. Le chantier à venir, articuler ces différents canaux pour offrir le meilleur des deux mondes : la rapidité du partage social, la rigueur et la profondeur de l’encyclopédie.

Pistes pour réinventer Wikipédia face à la montée de l’IA

Si la plateforme veut rester un phare dans la tempête numérique, elle va devoir non seulement s’adapter, mais aussi innover intelligemment. Intégrer davantage d’intelligence artificielle open source, renforcer les collaborations et l’éducation à l’esprit critique, repenser le modèle financier… Les options sont multiples, et aucune n’est à prendre à la légère.

- Déploiement d’outils IA open source maîtrisés par la Fondation et la communauté, pour garantir la transparence et l’éthique.

- Renforcement des réseaux de contributeurs bénévoles par la formation et la gratification.

- Création de passerelles entre contenus encyclopédiques et plateformes interactives de nouvelle génération.

- Développement de programmes éducatifs sensibilisant aux biais de l’IA (en savoir plus).

- Exploration de nouveaux modèles de dons et de financement, moins dépendants de la seule audience du site (étude sur l’IA et le capital risque).

Parmi les chantiers d’avenir, l’amélioration du balisage des contenus générés par IA se révèle aussi incontournable. Offrir au lecteur la possibilité d’identifier, en un clin d’œil, ce qui relève de la synthèse automatique et ce qui vient d’une rédaction humaine, participera à restaurer la confiance tout en encourageant le debate public.

Créer la symbiose entre humains & IA, le vrai défi

C’est le moment ou jamais de miser sur le collectif, la créativité et l’ouverture. Trop souvent, l’IA est vue comme une lame de fond incontrôlable. Or, encadrée, elle devient un formidable outil d’extension des capacités humaines. Lessentiel.lu rappelle qu’en renforçant l’esprit communautaire, l’encyclopédie peut transformer la pression concurrentielle en moteur d’innovation.

- Stimuler la collaboration internationale via WikiBooks et Wikiquote pour enrichir la diversité des regards.

- Mettre l’usager au centre des évolutions technologiques pour ajuster la plateforme aux nouveaux usages de demain.

- Influencer le débat public et politique sur la place du savoir en ligne dans la société connectée.

- Développer des partenariats audacieux avec les acteurs IA éthiques pour garantir la qualité, la transparence et la pluralité.

Si l’encyclopédie parvient à orchestrer cette transformation, elle pourra préserver sa position unique au cœur de la démocratisation du savoir, même à l’heure où l’intelligence artificielle rebat toutes les cartes. L’avenir n’est donc pas figé : il restera, plus que jamais, entre les mains d’une intelligence collective, hybride, inventive.